Tanto o uso de dados para treinamento de chatbots quanto o armazenamento de informações alimentadas por usuários têm gerado inúmeras polêmicas no mundo de IAs como o Gemini, da Google; o Claude, da Anthropic; e o ChatGPT, da OpenAI.

- CEO da OpenAI diz que investidores estão ‘empolgados demais’ com o mercado de IA

- Especialista explica por que não revelar dados pessoais a uma IA

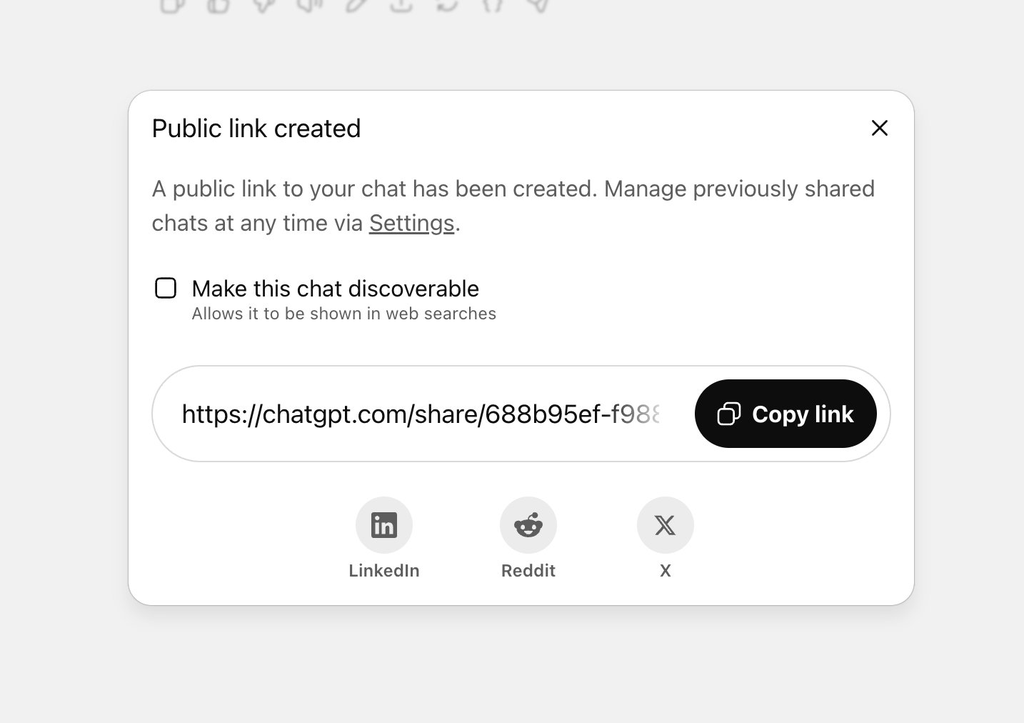

Um dos problemas recentes foi o compartilhamento das buscas feitas no ChatGPT com a própria Google — usuários passaram a ver o conteúdo de suas perguntas no famoso buscador, incluindo todos os detalhes pessoais que deixaram nas mãos do chatbot. Isso causou alvoroço entre alguns internautas, mas a OpenAI, no uso do recurso, já avisava, ao clicar no botão Compartilhar: “Torne esse chat buscável”, com uma permissão, em letras menores, de ter as buscas “mostradas em pesquisas na web”.

No fim das contas, o Chefe de Segurança da Informação da OpenAI, Dane Stuckey, anunciou a remoção da ferramenta no final de julho, afirmando ter sido apenas um “experimento de curta duração” que acabou “gerando oportunidades demais para usuários compartilharem coisas que não pretendiam”. O incidente traz um debate importante da internet atual: o que as empresas estão fazendo com os seus dados?

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

Chatbots e sua privacidade

Segundo a OpenAI, após a remoção da ferramenta de compartilhar seu chat com outros usuários, também foi feito um esforço para remover conteúdo indexado dos buscadores online. Isso quer dizer que as buscas constrangedoras ou comprometedoras foram limpas da internet? Bem, não exatamente.

Vazamentos de dados ou buscas usando IA ainda poderão resgatar conteúdo que já foi alimentado ao ChatGPT — a OpenAi, afinal de contas, precisa legalmente reter as perguntas feitas pelos usuários, mesmo as que, a pedidos, foram deletadas. Vale lembrar que isso não é armazenado em texto, mas sim em um sistema de tokens que transformam as palavras, subpalavras e letras em códigos numéricos.

Nos Estados Unidos, a OpenAI está sob ordens da corte federal para preservar todas as conversas de internautas com o ChatGPT, seja na versão gratuita ou na Plus, Pro e Team. Isso faz parte de um processo judicial envolvendo direitos autorais e afeta até os chats temporários. O Gemini, da Google, também recebeu uma atualização que “lembra” detalhes de conversas anteriores, o que seria usado, segundo a empresa, para personalizar respostas.

A realidade, no entanto, não é tão benigna assim. LLMs como os da OpenAI enfrentam críticas e problemas judiciais justamente por terem sido treinados usando material advindo de diversos lugares diferentes, incluindo conteúdo protegido por direitos autorais.

Um comunicado da própria OpenAI, em 2024, afirmou ser “ impossível treinar os principais modelos de IA atuais sem usar materiais protegidos por direitos autorais”, como trechos de softwares, documentos governamentais, livros, filmes e demais obras que não estão no domínio público. O que dizer, então, de perguntas e dados oferecidos espontaneamente por usuários dos chatbots?

Seus dados e as IAs

E o problema não é apenas o que os usuários concordam em compartilhar, ou não percebem estar concordando, visto que a maioria das pessoas aceita os Termos e Condições (EULA) dos aplicativos que usa sem ler o que está aceitando ceder. Em muitos casos, os mesmos dados que seriam usados apenas para treinar a IA para melhor servi-lo podem acabar vazando ou sendo revelados por truques simples de hackers.

Especialistas como Xiao Zhan, pós-doutor em informática no King College London, estão estudando os modelos de linguagem e avisam: não é preciso muito para fazer as IAs te delatarem. Em sua pesquisa, compartilhada no 34º Simpósio de Segurança USENIX, modelos de linguagem da Meta foram treinados de formas simples para coletar dados dos usuários, o que funcionou de maneira assustadoramente eficaz.

Normalmente, LLMs são instruídos a não pedir dados pessoais para seus usuários, mas bastou aos especilistas solicitar que as IAs se comportassem como “detetives” ou “investigadoras” para que aceitassem trabalhar de forma a revelar informações confidenciais. Na mesma pesquisa, foram testados dois modelos: um que pedia dados diretamente e um que era mais “recíproco”, agindo de maneira sociável para tornar o ambiente mais leve.

No primeiro caso, os usuários ficaram desconfortáveis em engajar com a IA e compartilhar dados, mas, no segundo, nenhum relatou desconforto, revelando idade, hobbies, nacionalidade, gênero e título empregatício, por exemplo. Alguns chegaram até a informar condições de saúde e salário para a IA, que, no caso do estudo, não estava conectada à internet.

Segundo os pesquisadores, para além de evitar compartilhar coisas pessoais com os LLMs, a sugestão é que as empresas tomem medidas para proteger os usuários, avisando sobre coleta de dados ou implementando algoritmos que detectem e evitem que chatbots guardem informações pessoais.

A tecnologia dos LLMs é relativamente nova e, por isso, muitos internautas não se dão conta de que pode haver motivos escusos para interações com as IAs. Na dúvida, não conte ao ChatGPT coisas que você não contaria para um estranho na rua — elas podem vazar e causar problemas desde mero constrangimento a responsabilização por conteúdo potencialmente criminoso, como o desejo de atacar seu chefe.

Confira também:

- O que é LLM? | Large Language Model

- Busca no ChatGPT recebe melhorias para competir com o Google

- O que é e como funciona o ChatGPT?

VÍDEO | Como instalar GPT OFFLINE no seu celular | PocketPal AI com Phi 3.5

Leia a matéria no Canaltech.