As técnicas de envenenamento de IA e injeção de prompt, acompanhando a evolução dos próprios large language models (LLMs), também estão ficando mais avançadas. Agora, cibercriminosos estão promovendo números falsos de call center e suporte ao cliente nas fontes públicas usadas pelos chatbots.

A análise, publicada na última segunda-feira (8) pela Aurascape e realizada pela equipe Aura Labs, revelou uma manipulação sistemática das fontes públicas de dados, o que foi chamado pelos pesquisadores de “envenenamento de números de telefone de LLM”. IAs afetadas incluem a Visão Geral da Google e o navegador Comet, da Perplexity.

Envenenamento de telefones na LLM

A diferença nesse tipo de ataque, de acordo com o estudo, é que a técnica não mira diretamente nos modelos de linguagem, mas sim em afetar o conteúdo que os chatbots pesquisam para dar suas respostas. Pense na Search Engine Optimization (SEO), ou otimização de motor de busca, em tradução livre, que consiste em modelar o conteúdo para que buscadores como o Google recomendem mais a sua página web.

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

O que ocorre nesse caso é a otimização de motor generativo (Generative Engine Optimization, GEO), que procura garantir que um site ou serviço online vire uma fonte usada para resumos de IA e pesquisas em chatbots. Isso é feito pelos golpistas ao subir conteúdo de spam em sites legítimos e confiáveis que foram comprometidos, como governamentais e de universidades.

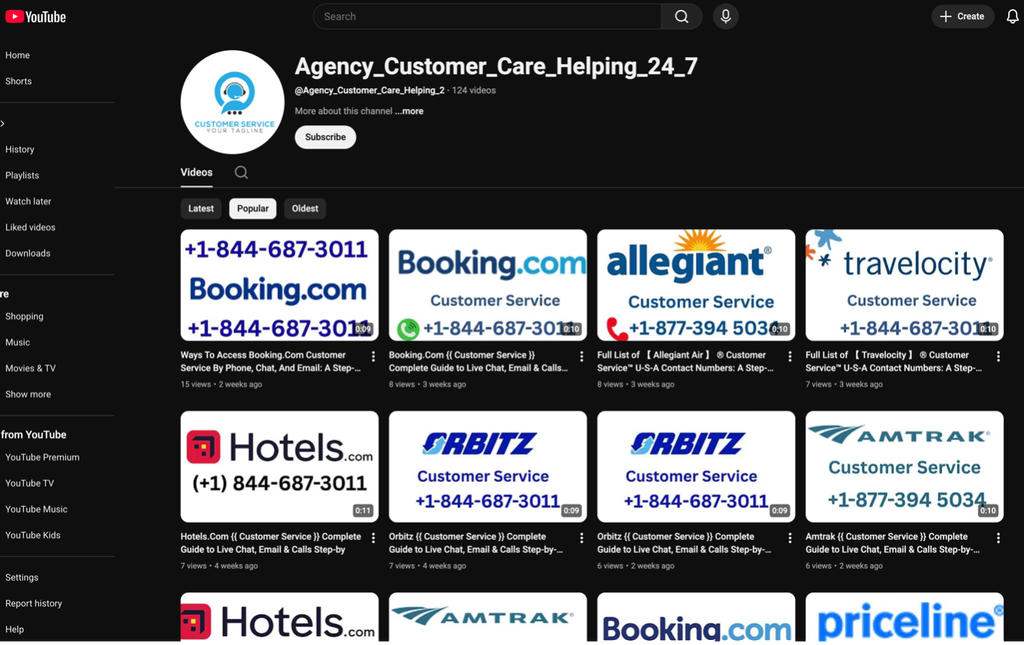

Serviços públicos que permitem conteúdo gerado por usuários também são abusados, como YouTube e Yelp, recebendo respostas e números de telefone falsos. Casos notados pelos pesquisadores incluem resultados de busca pelo número oficial de reservas para Emirate Airlines e British Airlines, que retornam call centers fraudulentos como se fossem respostas legítimas.

O problema principal, de acordo com a Aurascape, é que as LLMs puxam tanto conteúdo legítimo quanto fraudulento, dificultando a detecção de golpes. Isso tem o potencial de afetar não só Google e Perplexity, mas chatbots de IA como um todo.

A recomendação aos usuários é de sempre checar, na fonte e em outros sites, a veracidade da informação oferecida, especialmente no que tange a números de contato. Também é preciso evitar oferecer qualquer informação sensível a assistentes de IA, especialmente se lembrarmos o quão pouco eles foram testados até hoje: a conveniência da IA não quer dizer, de forma alguma, que ela é segura.

Leia também:

- Navegadores de IA não são seguros e precisam ser bloqueados, diz Gartner

- Falha no Gmail permite roubo irreversível de contas via controle parental

- Ataque de clique zero pode excluir todos os arquivos do Google Drive do usuário

VÍDEO | Chat GPT, Perplexity, Claude, Gemini: QUAL escolher?

Leia a matéria no Canaltech.