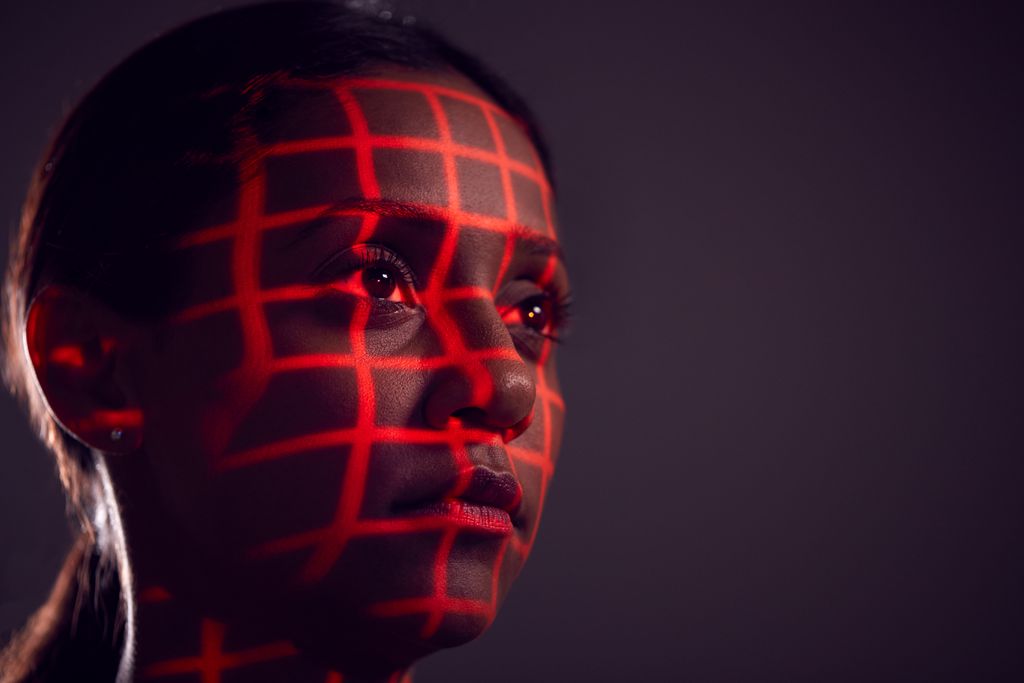

Pesquisadores da Universidade de Oxford apontam problemas sérios da tecnologia de reconhecimento facial usada por polícias de vários países para identificação de criminosos. Segundo eles, as condições reais são muito mais complexas do que as reproduzidas em laboratório, o que já levou a prisões de pessoas inocentes e diversos problemas nos Estados Unidos e Reino Unido, por exemplo.

- Veo3 pode ser usado para enganar sistemas de reconhecimento facial

- Microsoft anuncia nova tecnologia de reconhecimento facial com IA

Os cientistas responsáveis são Teo Canmetin, Juliette Zaccou e Luc Rocher, que analisaram a Avaliação de Tecnologia de Reconhecimento Facial (FRTE) do Instituto Nacional de Padrões e Tecnologia (NIST) dos Estados Unidos. Esse benchmark, ou ponto de referência, é usado para justificar o uso de sistemas de inteligência artificial na Polícia Metropolitana do Reino Unido — mas, segundo os estudiosos, tem muitos problemas.

Problemas do reconhecimento facial

Para começar, a avaliação falha em refletir as condições do mundo real, onde as imagens de rosto podem estar borradas ou escuras demais. Os bancos de dados usados também são muito pequenos, o que gera um impacto menor da identificação falha nos resultados. Por último, esses dados não condizem com os demográficos reais, tendo poucos exemplos de pessoas de gêneros e etnias diferentes — ou sequer os incluindo.

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

Falhas podem ser vistas na prática, como na identificação errônea de um homem em Detroit, EUA, em 2020, que foi preso injustamente. Outro crime em Londres teve o criminoso falsamente identificado, e, neste caso, um estudo da Universidade de Essex apontou que a tecnologia usada tinha identificado apenas 8 faces corretamente entre 42 em testes.

Em laboratório, os modelos de reconhecimento facial atuais chegam a uma precisão reportada de 99,95%, mas isso gera uma percepção distorcida de sua eficiência, já que as condições difíceis do mundo real não são replicadas nos estudos. Um estudo da Universidade da Pensilvânia, publicado neste ano, mostra que a performance dos softwares cai muito quando as imagens estão borradas e em baixa resolução, bem como quando as pessoas estão em poses variadas.

Falsos positivos e negativos também afetam desproporcionalmente mais os indivíduos de grupos marginalizados gênero e etnicamente. Outros métodos de identificação forenses, segundo os cientistas, são ainda piores, como digitais e testes balísticos, mas a baixa precisão não é o único problema apontado pelas pesquisas.

Agências policiais que usam a tecnologia não recebem treinamento adequado e não aplicam políticas de direito civil, algo que reportes do próprio governo dos EUA apontam. Um exemplo é o uso de reconhecimento facial em aeroportos sem o consentimento dos indivíduos, que podem negar passar por detectores do tipo. Um relatório de 2024 do Innocence Project já identificou sete casos de acusações falsas envolvendo pessoas pretas com base na tecnologia, e outras agências notaram mais dois casos neste ano.

A conclusão dos pesquisadores é de que o sistema ainda está muito falho e pouco testado para uso seguro no mundo real — e que não deveria estar sendo usado por policiais, como erros na identificação têm mostrado. Aos governos, sugere-se um uso mais consciente de tecnologias do tipo e a criação e aplicação de leis de direitos civis acerca do tema com maior atenção.

Veja mais:

- Microsoft recusou oferta em reconhecimento facial em favor dos direitos humanos

- Empresa é multada por coletar fotos online para sistema de reconhecimento facial

- Comissão do Senado é contrária a uso de reconhecimento facial pela polícia

VÍDEO | NÃO use o DESBLOQUEIO FACIAL, ele NÃO É SEGURO

Leia a matéria no Canaltech.