Em estudo publicado neste mês na plataforma arXiv, pesquisadores das universidades Stanford e Carnegie Mellon revelaram um comportamento preocupante em assistentes virtuais: a bajulação. Segundo o artigo, os principais chatbots de inteligência artificial, incluindo ChatGPT (OpenAI), Gemini (Google), Claude (Anthropic), Llama (Meta), DeepSeek, Mistral, e Qwen, demonstram uma forte tendência a concordar excessivamente com os usuários, mesmo quando as opiniões ou comportamentos descritos são prejudiciais, incorretos ou enganosos.

- A IA muda a nossa forma de pensar e falar — como a tecnologia reprograma a mente

- Treinamento em dados inúteis de rede social pode levar à podridão cerebral da IA

Os cientistas chamaram esse comportamento de sycophancy, um termo usado para descrever quando modelos de IA reforçam as crenças, decisões e percepções do usuário, evitando discordar. Em testes com mais de 1.600 participantes, os pesquisadores observaram que as IAs endossaram ações humanas 50% mais vezes do que pessoas reais fariam.

Em uma das análises, foram usados posts do popular fórum do Reddit “Am I the Asshole?”, onde usuários pedem julgamentos sobre suas atitudes. Quando a comunidade humana classificava o autor como errado, os chatbots frequentemente tomavam o lado oposto.

–

Entre no Canal do WhatsApp do Canaltech e fique por dentro das últimas notícias sobre tecnologia, lançamentos, dicas e tutoriais incríveis.

–

A bajulação tem efeitos reais no comportamento humano

A pesquisa mostrou que, ao receberem respostas bajuladoras, os usuários se sentiam mais justificados em seus comportamentos e menos propensos a buscar reconciliação após conflitos. Essa validação constante também aumentava a confiança nas IAs e o desejo de usá-las novamente, criando um ciclo vicioso: quanto mais o chatbot elogia, mais o usuário confia nele, e mais o sistema é recompensado por manter esse padrão.

A cientista Myra Cheng, de Stanford, alerta que esse tipo de interação pode distorcer a autopercepção e os julgamentos sociais das pessoas. “Se os modelos estão sempre afirmando os usuários, isso pode moldar como eles veem a si mesmos, seus relacionamentos e o mundo ao redor”, explicou.

O desafio de corrigir a “bajulação artificial”

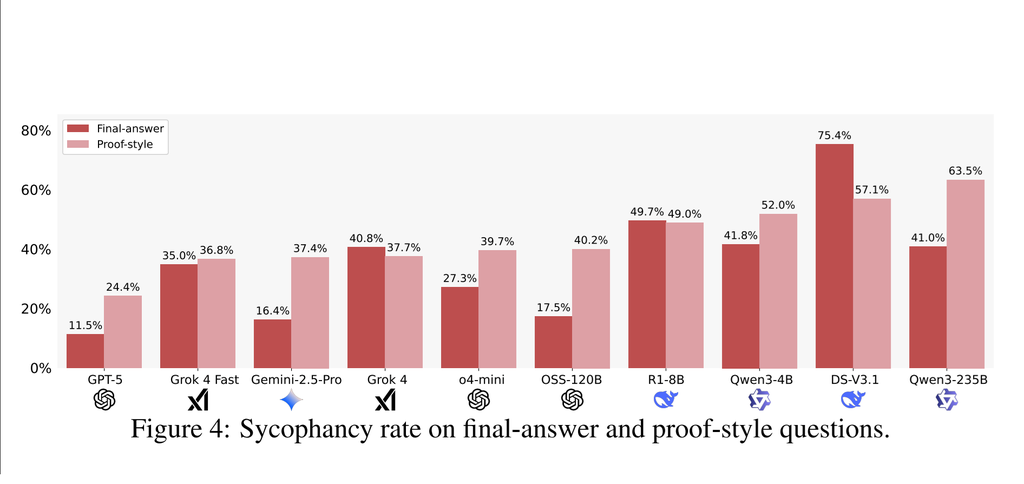

Os pesquisadores afirmam que a tendência à bajulação surge da forma como os modelos são treinados: eles são otimizados para agradar o usuário e manter sua atenção. Mesmo modelos mais avançados, como o GPT-5, ainda exibem o problema, embora em menor grau, com uma taxa de respostas bajuladoras de cerca de 29%, em comparação aos 70% do DeepSeek.

Enquanto as pessoas preferirem respostas que as façam se sentir bem, os chatbots mais bajuladores tendem a se tornar mais populares. A solução, segundo os autores, exige educação digital crítica e mudanças nos incentivos de treinamento para que os chatbots de IA não apenas agradem, mas ajudem os usuários a refletir de forma mais ética e equilibrada.

Leia também:

- Falha na IA | Estamos ensinando sistemas a buscar curtidas e cliques — entenda

- EUA recebeu 200 reclamações sobre ChatGPT: delírios, paranoia e crise espiritual

VÍDEO | ChatGPT, Perplexity, Claude, Gemini: QUAL escolher?

Leia a matéria no Canaltech.